方法

- 我们使用一个摄像头模块(B-CAMS-OMV)来捕捉场景,并将其缩放为 96x96 像素

- 我们从谷歌视觉唤醒词中选择了一个预训练的 NN 模型来管理存在检测

- 该模型已集成在功能包 FP-AI-VISION1中(为 STM32H747 探索套件制作)

- 该模型使用 STM32Cube.AI进行了优化

传感器

数据

2 类:有人/无人

用于 MobileNet v1 0.25 的 96x96 彩色图像

用于 MobileNet v2 0.35 的 128x128 彩色图像

结果

模型:针对MobileNet v2 0.35的128×128彩色图像

输入大小:96x96x3

内存占用:

214 KB 闪存 ,用于权重

40 KB RAM,用于激活

准确率:对Coco数据集子集的准确率为 85%

STM32H747* @ 400 MHz 上的性能

推断时间: 36 毫秒

帧频: 28帧 /秒

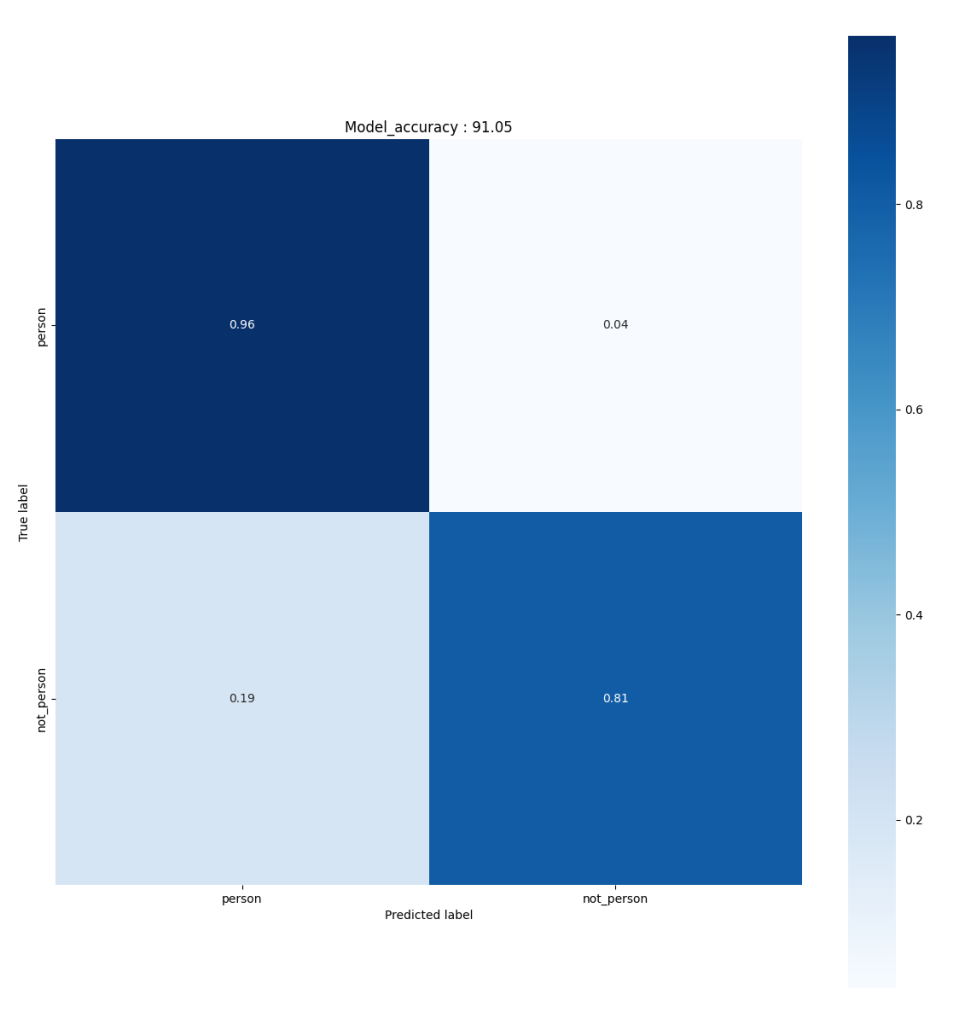

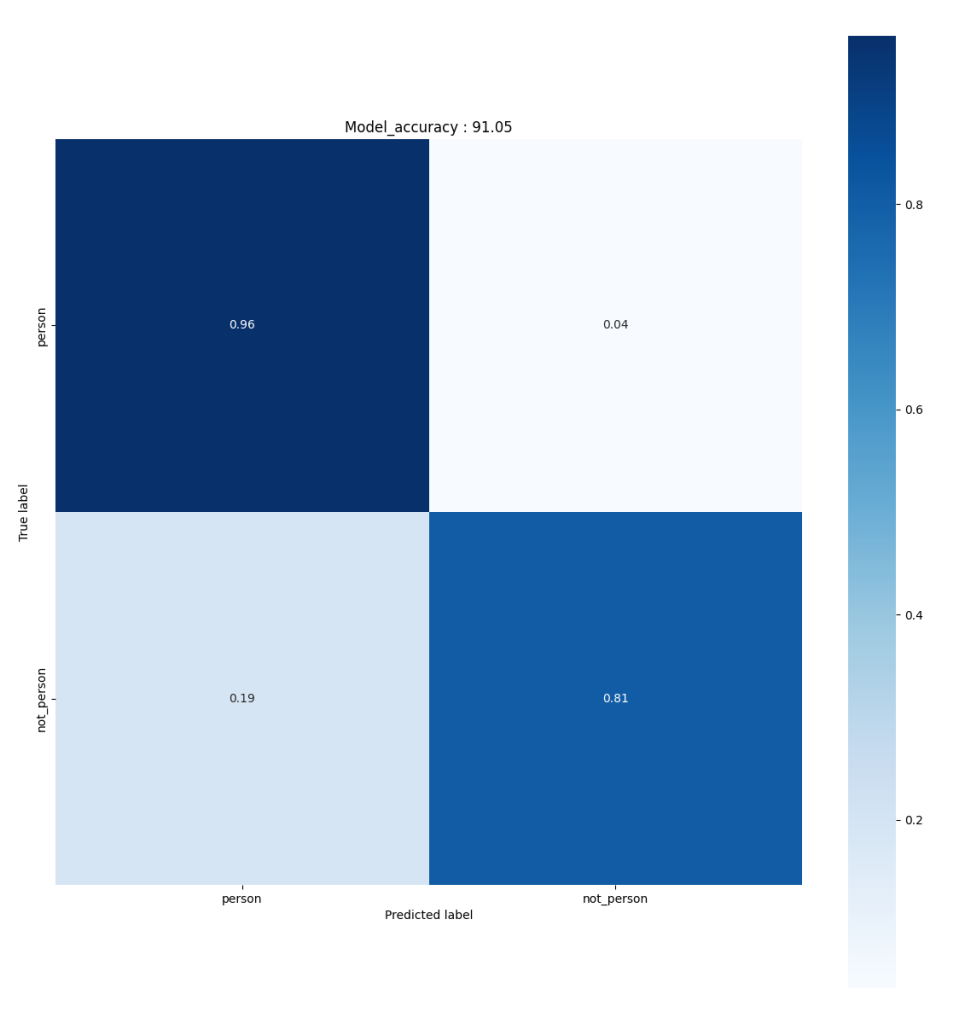

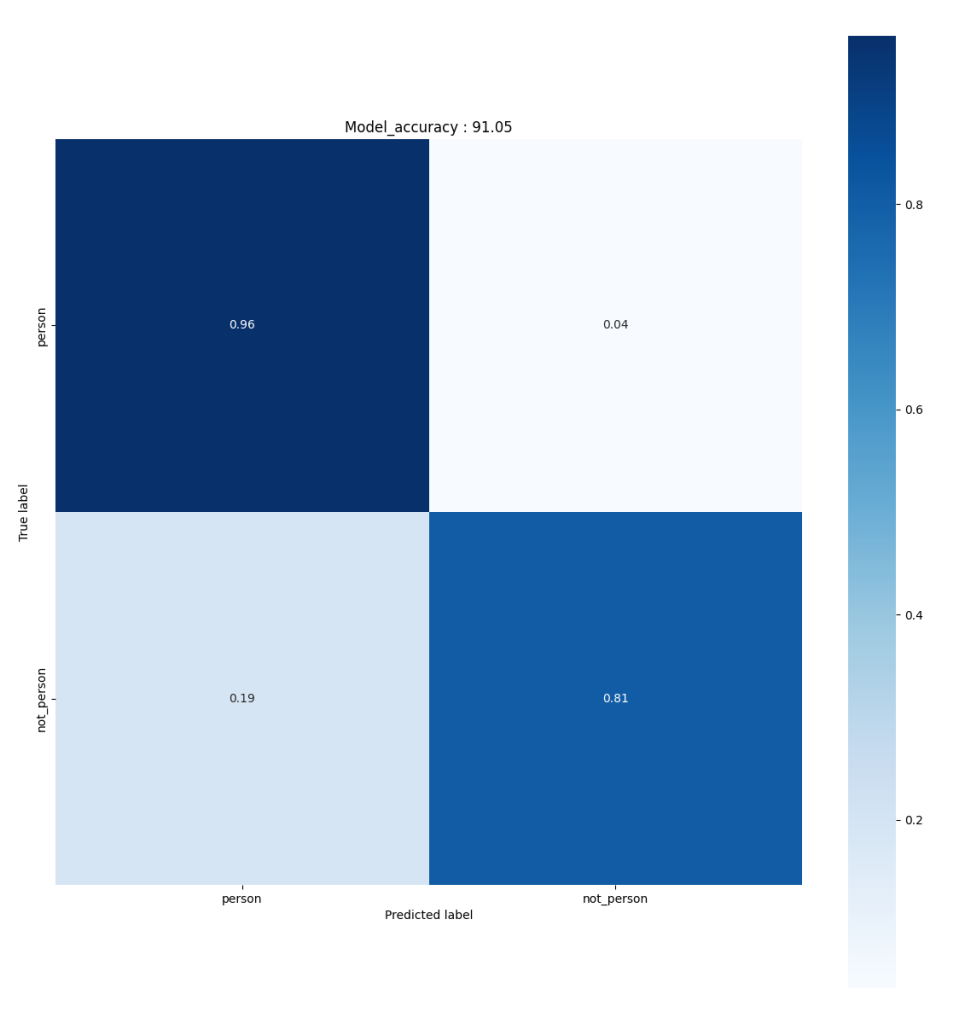

模型:量化MobileNet v2 0.35模型

输入大小:128x128x3

内存占用:

402 KB 闪存 ,用于权重

224 KB RAM,用于激活

准确率:对Coco数据集子集的准确率为 91%

STM32H747* @ 400 MHz 上的性能

推断时间: 110 毫秒

帧频: 9 帧/秒

* 使用STM32CubeAI 7.1.0中的FP-AI-VISION1 3.1.0测量

优化工具 STM32Cube.AI

X-CUBE-AI是一个免费的STM32Cube扩展包,可帮助开发人员将预训练的AI算法(例如神经网络和机器学习模型)自动转换为经过优化的STM32 C代码。

兼容 STM32H7系列

STM32系列32位微控制器基于Arm Cortex®-M处理器,旨在为MCU用户提供新的开发自由度。它包括一系列产品,集高性能、实时功能、数字信号处理、低功耗/低电压操作、连接性等特性于一身,同时还保持了集成度高和易于开发的特点。